Dit zijn de vijf meest gemaakte fouten bij Google Ads Experimenten

Het is de droom van iedere SEA marketeer: perfect opgezette online campagnes waar andere marketeers alleen maar van kunnen dromen. Om deze droom te realiseren zijn marketeers dagelijks bezig om optimalisaties door te voeren in campagnes. Een grote fout die veel marketeers maken is het lukraak doorvoeren van allerlei aanpassingen zonder deze vooraf te testen. Hoe weet je zeker dat deze aanpassing niet negatief uit gaat pakken voor je campagnes? Het antwoord? Door het te testen met een Google Ads experiment!

Wat is een experiment?

Een experiment is een kopie van een campagne die je met gewijzigde instellingen laat lopen. Het experiment loopt parallel aan de originele campagne, waarbij het verkeer (meestal) evenredig wordt verdeeld over de variaties.

Je kunt er ook voor kiezen om het verkeer anders te verdelen, maar met een 50/50 verdeling kun je de resultaten het beste vergelijken.

Fout 1: Geen gebruik maken van een hypothese

Probleem: Te korte experimenten en niet significante resultaten

De meest gemaakte fout bij het A/B testen binnen Google Ads is het niet formuleren van een hypothese. Veel marketeers testen iets waarvan ze graag het resultaat zien, zonder van tevoren verwachtingen op te stellen.

Uiteraard kun je dit doen en de wijziging in het experiment overnemen als de resultaten goed zijn. Maar zonder hypothese is het lastig om vast te stellen hoe lang je test mag duren. Standaard stelt Google een looptijd van een maand voor, maar in veel gevallen is dit te kort. Het resultaat van een te korte looptijd is een test die te kort heeft gelopen om er iets zinnigs over te zeggen. Dat je onvoldoende data hebt kunnen verzamelen om significante conclusies te trekken.

Met een hypothese kun je de impact op het verkeer en de conversies enigszins voorspellen. Deze verwachte resultaten zet je, samen met het verkeer en de conversies van de huidige campagne in een online significantie tester (bijvoorbeeld hier). Als de verschillen niet statistisch significant zijn binnen een looptijd van een maand, kun je de looptijd verlengen naar bijvoorbeeld twee maanden.

Fout 2: Meerdere dingen tegelijk testen

Probleem: Onmogelijk om te achterhalen welke aanpassing voor welk resultaat zorgt

In hun enthousiasme beginnen veel marketeers met allerlei wijzigingen door te voeren in hun experiment. Ze willen bijvoorbeeld een nieuwe biedstrategie testen, maar wijzigen gelijk de advertentieteksten en voegen als test een nieuwe audience toe.

Vervolgens willen ze het experiment analyseren. Maar dat blijkt onmogelijk. Ongeacht of de resultaten beter of slechter zijn. Je kunt op deze manier niet weten welke aanpassing welk effect heeft gehad op de campagnes.

Bij een zuivere A/B test pas je slechts 1 onderdeel aan, zodat je precies de impact van die aanpassing kunt zien. Na het experiment kun je bepalen of je de aanpassing definitief doorvoert in je campagne of niet. Daarna kun je een nieuw experiment opzetten om je volgende idee te testen of om je originele hypothese aan te scherpen en opnieuw te testen.

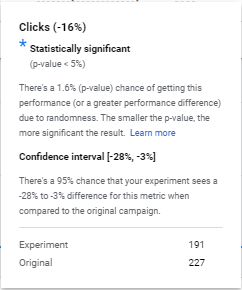

Fout 3: Niet significante resultaten

Probleem: Je testresultaten kunnen toevalstreffers zijn en daarom dus nietszeggend

Een veelvoorkomend probleem bij leadgeneratie campagnes is een gebrek aan verkeer. Minder verkeer betekent minder data om op te sturen en daarom minder betrouwbare testresultaten.

Stel daarom altijd een hypothese op en maak vooraf gebruik van een significantie tester. Google Ads geeft zelf aan of een testresultaat significant is of niet. Als een testresultaat niet significant is, dan bestaat er een grote kans dat de verschillen door toeval zijn ontstaan en bij een volgend experiment heel anders zullen zijn.

Zorg er in dit geval voor dat je test loopt met een langere looptijd of geef je campagnes meer budget, zodat deze meer traffic krijgen, waardoor resultaten sneller significantie krijgen.

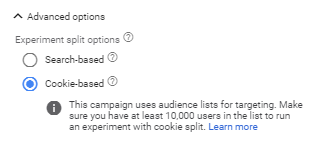

Fout 4: Cookie vs search based settings

Probleem: Een verkeerde setting kan ervoor zorgen dat je minder snel data verzamelt

Als je een experiment aanmaakt kijk je snel voorbij het kopje met geavanceerde instellingen. Hier kun je namelijk bepalen of je je experiment toepast op mensen die al op je website zijn geweest en waarvan je dus een cookie hebt verzameld.

- De cookie based instelling zorgt ervoor dat mensen die al in je remarketinglijst vallen de originele versie van je campagne te zien krijgen. Zij vallen dus niet in het experiment. Deze optie is alleen raadzaam als je meer dan 10.000 cookies in je remarketinglijsten hebt. Anders zul je minder snel data kunnen verzamelen.

- De search based instelling maakt geen gebruik van audience lijsten. Hierbij krijgen mensen dus willekeurig de originele campagne of het experiment te zien. Als je weinig remarketinglijsten hebt is dit de snelste manier om data te verzamelen. Dezelfde gebruiker kan dus zowel het origineel als de variatie (het experiment) van een advertentie te zien krijgen.

Let op! Deze instelling staat standaard op cookie based.

Fout 5: Testen tijdens piekseizoen

Probleem: Resultaten zijn niet reëel voor de rest van het jaar

Wanneer je als retailer een experiment lanceert midden in de sale periode, kun je hele andere resultaten zien dan wanneer je een experiment opzet buiten de sale periode. Mensen zullen tijdens de sale namelijk sneller op je advertentie klikken en waarschijnlijk meerdere producten aanschaffen. Testresultaten kunnen op deze manier wel statistisch significant zijn, maar niet realistisch voor de rest van het jaar.

Om deze reden is het, wanneer je test gericht is op het behalen van conversies, raadzaam om alleen te testen in een normale periode zonder sale of speciale evenementen. Als je advertentieteksten test met als doel een hogere CTR te behalen kun je dit gewoon doen tijdens piekseizoen.

Stappenplan voor een perfect experiment:

- Bepaal wat je wilt testen.

- Hoeveel verkeer en conversies krijgt je campagne in 30 dagen?

- Wat is je hypothese? Met andere woorden, wat verwacht je dat het effect gaat zijn van je test?

- Zet deze data in een online significantie tester. Is de impact significant (dus een p-waarde van <0,05)? Mooi. Zo niet, neem dan een langere looptijd voor je experiment.

- Bepaal hoe groot je remarketinglijsten zijn. Bij minder dan 10.000 cookies kies je voor search-based split. Anders kies je voor cookie based. Als je test puur is gericht op het verkrijgen van een hogere CTR dan kun je hier weer beter kiezen voor search based.